近日,人工智能领域顶级期刊《Information Fusion》(IF=14.7),在线发表测绘遥感信息工程国家重点实验室贺威教授课题组研究成果。论文题为“STFDiff: Remote sensing image spatiotemporal fusion with diffusion models” (基于扩散模型的遥感影像时空融合),博士生黄和为第一作者,贺威教授为通讯作者,合作者还包括夏宇博士,张洪艳教授和张良培教授。

具有连续时间的高分辨率遥感图像在近年来众多实际遥感应用中发挥了重要作用,例如灾害检测、作物产量估算和地表物体分割。然而,由于硬件限制,影像的时间分辨率与空间分辨率之间存在制约关系,导致遥感影像在这两方面的不足,显著缩小了应用范围。时空融合(STF)方法旨在融合具有不同空间和时间分辨率的卫星图像,为此提供了一种灵活高效的解决方案。然而,由于遥感影像之间存在空间差异大、时间变化复杂和光谱变异性强等不确定性因素,现有方法在复杂多样且具有显著动态变化的场景中表现有限。如何有效处理空间、时间和光谱的不确定性,成为现有时空融合方法面临的重大挑战。

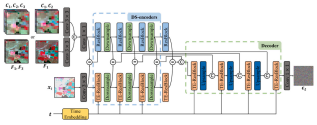

实验室博士生黄和提出了一种利用扩散模型的时空融合方法(STFDiff),该方法将预测日期的低分辨率图像与其他日期获得的低/高分辨率图像对进行融合,以生成预测日期的高分辨率图像。STFDiff通过从初始化的高斯噪声出发,在不同日期的先验图像的引导下,反复细化生成高分图像。在每次迭代中,基于先验影像和高分影像在时间上的近似关系,构建了一个基于双流U-Net(DS-Unet)的条件噪声预测器。DS-Unet首先利用双流编码器(DS-encoders)分别提取先验影像和带噪高分影像的特征,然后进行相减操作以增强噪声特征,最终解码出噪声信号。因此,在每次迭代中,考虑了影像间的时间关系,减轻了时间不确定性。另外,在迭代的前期,STFDiff致力于光谱恢复;而在迭代后期,则专注于空间细节的复原。最终生成的高分辨率图像在空间细节上与先验高分图像相似,并在时间动态上与先验低分图像相似。实验证明,STFDiff方法的融合结果在图像质量上优于现有的最优方法,并且生成的融合影像在下游分类任务中取得了更接近真实影像的分类结果。

图1 STFDiff框架

贺威教授带领的“高分辨率智能信息处理与应用(HiPAG)” 长期专注于遥感影像智能处理与应用相关的研究工作。最新成果“GRiD: Guided Refinement for Detector-free Multimodal Image Matching”发表在图像处理顶刊IEEE TIP;“Harmony in diversity: Content cleansing change detection framework for very-high-resolution remote-sensing images”发表在遥感领域顶刊ISPRS Jounal;" High-resolution comprehensive regional development mapping using multisource geographic data"发表在城市规划领域顶刊Sustainable Cities and Society。

相关论文链接:

https://doi.org/10.1016/j.inffus.2024.102505

https://doi.org/10.1109/TIP.2024.3472491

https://www.sciencedirect.com/science/article/pii/S092427162400340X

https://doi.org/10.1016/j.scs.2024.105670

团队公众号:EarthVision Application