核心提示: 随着我国遥感对地观测技术的快速发展,接收和存档的遥感影像数据量呈指数级增长,由于遥感影像内容理解和快速检索技术缺乏突破性进展,使得遥感影像利用率和利用效率十分有限。与此同时,快速发展的人工智能技术已在影像、语音等诸多领域取得重大进步。在GeoScience Café第192期活动中,龙洋(武汉大学测绘遥感信息工程国家重点实验室硕士研究生),将重点介绍基于深度学习的大规模遥感影像检索等相关工作,以及在遥感影像深度特征理解方面的探索,同时介绍以此为基础的遥感影像目标检测等相关研究及成果。

主持:纪艳华 摄影:韦安娜 摄像:郑镇奇 文字:赵书珩

>>>人物名片

龙洋,硕士研究生,师从肖志峰老师。研究方向:遥感影像检索、目标检测、机器学习等。硕士研究生期间以第一作者或通讯作者(导师一作)在IEEE TGRS、Remote Sensing期刊发表SCI论文两篇,会议论文一篇。获得硕士研究生国家奖学金,测绘遥感信息工程国家重点实验室研究生创新奖等。

>>>报告现场

2018年4月13日,龙洋做客Geoscience Cafe第192期学术交流活动,分享了自己与团队进行的基于深度学习的大规模遥感影像检索等工作,同时介绍以此为基础的遥感影像目标检测等相关研究及成果。

背景

由于近年来遥感对地观测技术的高速进步,遥感影像的分辨率得到提高,卫星数量与传感器种类逐渐增加,我们所拥有的遥感影像数据量呈现爆发式增长。龙洋在此以ZY-3号卫星为例,这颗对地观测卫星每天获取的数据量可达10TB以上,若以0.5米分辨率遥感影像覆盖全国,则将有约7亿瓦片影像。多时相、多传感器遥感影像的爆炸式增长,对于遥感版的搜索引擎的需要也变得更加迫切。

龙洋通过对比遥感影像与自然影像,阐明了遥感影像大数据非结构化、难以描述、难以理解的特点。从“质”和“量”来说,对大规模遥感影像进行检索是非常困难的。对此龙洋认为有两点关键技术问题需要突破,一是“准”,即为准确地表达复杂遥感影像的语义内容;二是“快”,能快速地从海量遥感影像中检索满足条件的影像。那么我们将如何从超大规模的遥感影像数据库中发现可能感兴趣的内容呢?

传统检索模式

接着龙洋带领大家对传统的遥感影像检索模式进行了一个回顾。传统的检索模式基本上是基于影像元数据的方式,根据遥感影像的元数据进行检索,如地理位置、传感器类型、坐标系统、分辨率、时间等,将影像检索问题简化为常规数据库的属性检索问题。所以传统方法在实现遥感影像检索的时候一般都是基于元数据或者关键字。比如说:寻找某地的、分辨率小于特定尺度的影像,我们可能就得在一个专业系统中去写一行代码,这种检索模式虽然精度会非常高,但是它需要专业的用户进行操作,普通用户很难使用。在美国和德国都有着这样的检索系统,但这种检索模式缺乏对影像内容的理解,很可能导致检索结果不符合用户标准;也有研究基于人工设计特征进行影像内容表达,采用这种量化方式对遥感影像进行内容检索,结果不是那么优秀,其面对的数据规模也相对较小;并且在传统的基于地名检索的模式中,当我们需要检索一幅缺少元数据信息的影像内容时,就会感到无能为力。这也是传统遥感影像检索中存在的不足。

从文本检索到内容检索,从架构导向到任务导向

值得庆幸的是,我们已经从文本检索的时代来到了内容检索的时代。基于内容检索的基本模式是:在遥感影像数据库中,将所有影像以特征的方式进行量化表达,然后用相似性度量方法进行相似影像的匹配,这是通用的做法。当然也有做相似性度量方法学习的,这对于提升相似影像匹配的精度是非常有帮助的。

更值得庆幸的,我们在特征提取方法研究上有了很大的进步。这里列出了一些经典的用于遥感影像检索的深度卷积神经网络模型(图1)

图1经典的深度卷积神经网络模型

几乎所有人都使用CNN的全连接层作为特征使用,维度从几百维到几千维,很少有人探究过维度问题。同时,直观的想法可能认为高维的信息更有助于进行复杂影像内容的表达。然而在面对海量的遥感影像数据检索时,高维特征会对影像检索速度、存储等带来严重问题,这在遥感影像检索任务中表现尤为突出。

2014年,龙洋在ECCV上看到了一篇论文,作者使用PCA对影像的深度特征进行降维,进一步推进了检索的工作,虽然精度不高,但是也引起了他的思考。他在此基础上做了很大的改进,并进行了实验,在提升精度的同时提升了检索速度,同时大大降低了影像内容表达的存储成本。

面向大规模高分辨率遥感影像库的智能检索方法

接着龙洋向大家介绍了面向大规模高分辨率遥感影像库的智能检索方法。

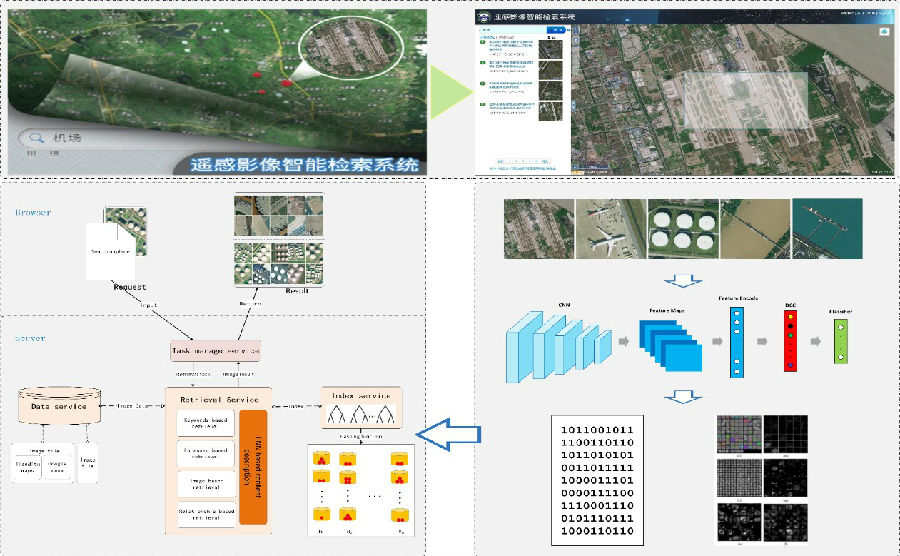

首先他提出了基于深度级联降维网络结构的遥感影像地物特征提取方法,能够使用较少的计算代价获得较高的内容特征表达能力。对比常规卷积神经网络,不同维度降维模型取得的检索效果均有显著提升,从4096维到64维,每降低一个维度,Alexnet和VGG模型检索精度均提升约3%左右,所有降维模型检索效果均优于对应原始模型的检索效果,模型性能最高提升约9%左右。

图2 不同降维模型检索精度

那么为什么降维模型取得了如此显著的性能优势?龙洋观察了深度卷积神经网络内部,提出了深度特征可视化方法,探索深度特征图中隐藏的目标信息。通过可视化表达,他发现降维网络逐步剔除特征中的冗余信息,保留了最核心的影像内容特征。同时降维特征能够保留更为纯净的类别信息,能够有效提升分类效果,因而具有更强的特征表达能力。

龙洋也将级联降维方法应用于遥感影像目标场景识别,他举出了其中一些例子,如将同一网络应用于目标检测的结果。虽然对比其他方法查全率有些许降低,但精度相对提高很多,这种代价也是值得的。

在解决精度与存储的问题后,他采用了哈希的方法解决速度问题。他设计了端到端学习的深度哈希索引方法,该方法利用深度卷积神经网络特征,提取旁路输出深度特征进行融合,并学习得到哈希特征,在提升影像哈希特征表达能力的同时,大幅提升影像的索引效率。

图3以距离真值作为算法评价方案,采用局部敏感哈希索引方法的检索性能

同时龙洋共享了团队的Github:https://github.com/RSIA-LIESMARS-WHU/LSHBOX,方便更多的人学习与使用。

接着龙洋向大家展示了面向天地图平台的大规模遥感影像智能检索系统的架构,它支持全国300个城市0.5米分辨率影像,90万平方千米2米分辨率影像检索,达到秒级响应时间,支持包含文字,语义,影像在内的多种检索方式。

图4面向天地图平台的大规模遥感影像智能检索系统

通过与国际知名的TerraPattern以及传统的检索系统对比,该系统在城市规模、检索目标、检索模式、结果类型、检索速度与准确度上都有极大的优势。

图5 该系统与国际知名的TerraPattern及传统的检索系统对比

接下来龙洋演示了团队的检索系统,在不同检索模式下对不同对象、场景和地物进行检索与结果展示,为我们展现了系统的检索速度与精度。最后也向大家介绍了基于弱监督深度学习方法进行遥感影像目标定位检测的相关研究及成果。

>>>互动交流

提问环节,观众们热情高涨,嘉宾选取了几位观众进行交流,并送出了由café出版的第二卷《我的科研故事》作为提问奖励。

观众A:我想问一下师兄,在最后的弱监督目标定位那里,验证的时候使用框把目标圈出来了,但是定位的时候却是一个点,为什么不在定位的时候就用框把目标圈出来呢?

龙洋:我们试过,但是可以看到每一个影像的阈值对于目标响应图的效果可能是不一样的,如果这么做的话,可能会导致每个对象边界框定位没有那么准确。但是如果我们能够定位到目标对象本身的话,意义和效果上应该比仅仅给出目标边界框更好。这个问题其实可以说是常规的目标检测与我们提出的目标定位框架的区别。目前我还没有看到过采用这种方法的,这可能也是因为我们第一次做这个工作吧,后续也会继续改进的。

观众B:你好,我看到你在做这个网络的时候,用的AlexNet和VGG,我想问一下你有没有尝试过在前面分类的地方采用降低卷积滤波器数量的方式来进行降维呢?如果做过的话效果怎么样?第二个问题是你使用的哈希的方法,我记得你提到的是融合多路的哈希值,融合多路是不是就是将后面那几个低层提取出的特征每一个都用上,这样用的原因是考虑到多尺度的原因其他什么原因?第三个问题是在目标定位,指标是一个点,如果点在框内则定位成功,如果点在框外则没有匹配上,是这样吗?

龙洋:首先第一个,抱歉的是我们并没有在这方面做过探索,因为CNN框架中卷积滤波器的参数规模相对于全链层的参数很小,同时我们更关注最终影像特征表达的效果,所以没有对降低卷积滤波器数量进行过探索。如果你在这方面有什么探索的话,希望你能和我们分享一下(笑)。然后第二个问题,我们之前看到过一些文献,其实每一层特征都是有效果的,如果能够集成优势不是会更好?而且哈希本来就会损失信息,我们采用这种方法也是为了达到一个增强信息的目的。第三个的话,我们是认为点落在框里就算定位成功,但我们想更进一步地去做点落在飞机本身上,但是这样的话就需要影像分割的标注数据了,所以目前还没有做落在飞机上这种工作,我们也会在后面更进一步加强这一工作。

观众C:你好,我想问一下特征可视化那一块儿,特征值是怎么保持原始影像大小的呢?

龙洋:这个问题很细节,直接做一个简单的上采样就可以了。

观众C:那结果不会出现格网的效果吗?

龙洋:不会,我们直接上采样就可以得到这样的结果。当然采用反卷积网络框架进行学习的方式都可以。

观众D:你好,我想请问一下在可视化那一部分中,Feature Maps它们之间的关系是怎样的?第二个问题是最后做的弱监督的目标定位,其实它还是和目标检测有区别,它只需要把点定位出来就可以了,您对于定点提出了一个动态的阈值分割,我想如果把可视化结果中所有结果区域分割出来,然后再找到几何的质心或者什么点,能否也达到类似效果?还有一个问题就是您平时在深度学习的时候调参数的心得可以分享一下吗?

龙洋:直接可视化卷积层的特征图的话,你其实不知道它里面有什么东西,它所关注的信息,每一个维度都不一样,可能无法判断它们之间的关系。刚刚那个同学也讲过,我们的出发点是和传统的目标检测不一样的,也没有之前的工作可以参考,所以我们的评判标准的确不一样。我们也做过其他尝试,也有很多失败的案例,但是因为噪声信息太多了,微弱的噪声就会产生严重影响,所以我们最终设计了这种极值的方法去判断。您提到的这种方法,我们也做过类似的工作,但是由于我们是弱监督的方法,无法判断分割出来的框里哪一个区域是我们需要的,所以这种方法失败了。最后一个问题,我主要还是调整学习率和Batch Size的大小。网上应该有很多相关资源,您也可以参考一下网上的经验。其实调参也没有一个统一的模式去进行,有时候也靠自己的经验积累。

图6 主持人宣布报告开始

图7 龙洋做精彩报告

图8 观众认真听报告

图9 报告后交流

图10 龙洋(第一排右二)与GeoScience Café团队成员合影留念

GeoScience Café以“谈笑间成就梦想”为口号,采取最自由的交流方式,每期邀请1-4位报告人,针对自己正在进行的研究展开报告。每周五晚7:30,在测绘遥感信息工程国家重点实验室四楼休闲厅举行当期活动。报告内容不仅涉及一切与测绘有关的学科内容及学术方法,如测绘基础学科、地理信息系统、摄影测量与遥感、全球定位系统、激光雷达技术、信号处理,还包括地理信息科学以外的话题,如法律和艺术等。让任何感兴趣的人——不仅是地理信息相关专业的师生,还包括其他专业的师生,甚至是文科生——都可以听取报告,并当场向主讲嘉宾提问或者会后与其交流。

更多精彩内容(报告PPT、新闻稿及下期活动消息等)敬请关注Geoscience Café群(QQ群号:532362856),微信公众号:GeoScienceCafe

欢迎扫描二维码: