近日,我室涂志刚研究员课题组在国际人工智能领域顶级期刊《IEEE Transactions on Pattern Analysis and Machine Intelligence》(IEEE TPAMI, 影响因子23.6) 发表题为“A Modular Neural Motion Retargeting System Decoupling Skeleton and Shape Perception”的学术论文。

论文的第一作者为实验室博士研究生张嘉旭,通讯作者为涂志刚研究员。武汉大学计算机学院杜博教授,美国纽约Buffalo大学Junsong Yuan教授为论文共同作者。

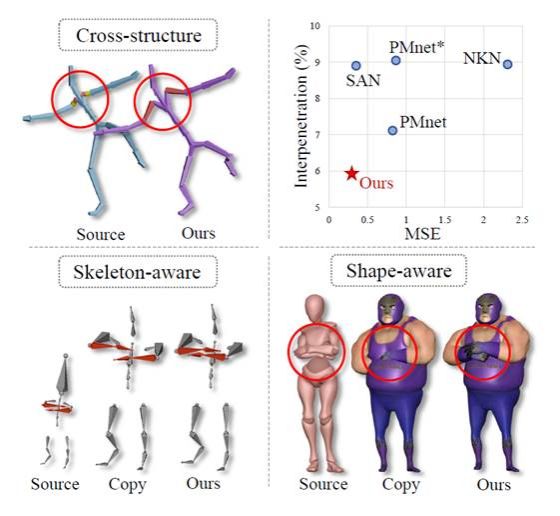

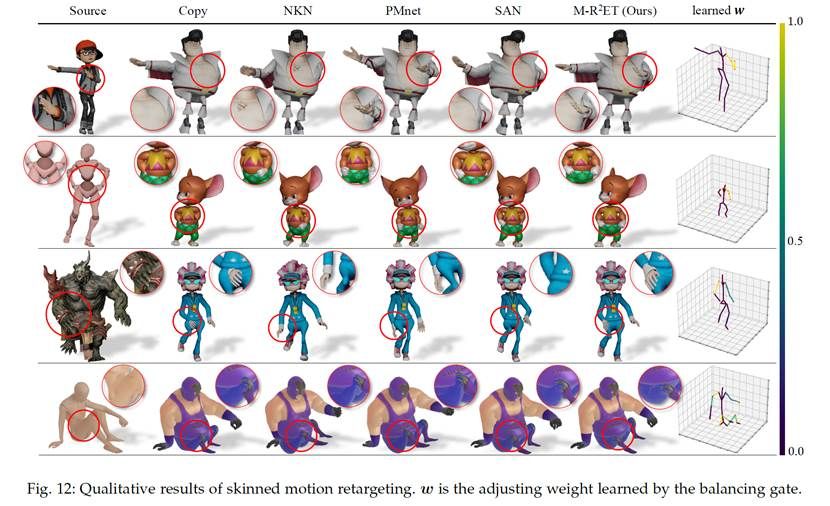

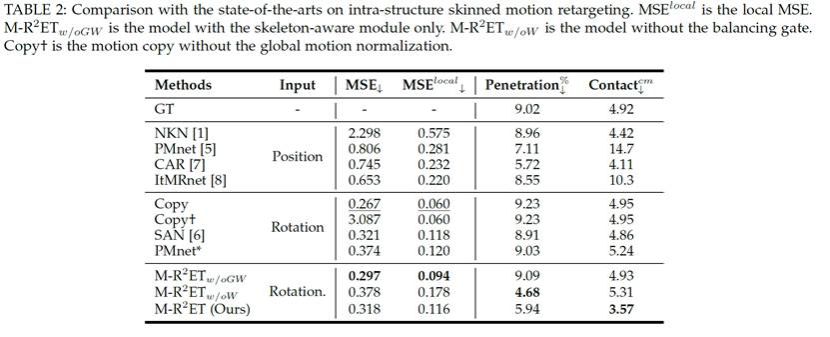

课题组创新性地提出了一种用于蒙皮角色的模块化神经网络运动重定向系统(M-R2ET),实现了模块化解耦的跨骨骼结构动作映射、动作语义与角色身体形状感知。M-R2ET在重定向结果中有效保留了动作语义,减少了角色自身穿模,同时维持了动作的一致性与逼真性。经公开数据集Mixamo实验验证,M-R2ET超越了现有运动重定向技术,在精度与几何质量方面均达到了领先的性能。

M-R2ET系统能进行跨骨骼运动重定向、感知角色的骨骼与形状差异

研究背景

运动重定向(Motion Retargeting)是3D视觉与动画领域的一个重要的问题,它的目的是将一段源角色的运动迁移到目标角色上,同时维持运动本身的语义以及合理性。传统的运动重定向方法通常利用一些运动学的约束,对目标角色的运动进行优化。例如找到角色之间对应的骨骼进行motion copy,或是通过IK过程利用源角色骨骼结点的位置恢复出目标角色的运动,再通过后处理或是人工微调来保证运动重定向结果的质量。该过程需要一些专业的知识技能。同时,对于不同的角色,不同的运动,通常需要根据实际情况设计不同的约束条件,因此应用门槛较高。现有利用深度网络进行运动重定向的方法,通常采用数据驱动的策略,端到端地将源角色的运动映射到目标角色的骨骼结构上。但是这种全映射的策略通常难以学习,容易造成运动失真,也未充分考虑角色骨骼和形状差异所带来的动作语义丢失与穿模问题。

运动重定向M-R2ET系统架构

方法介绍

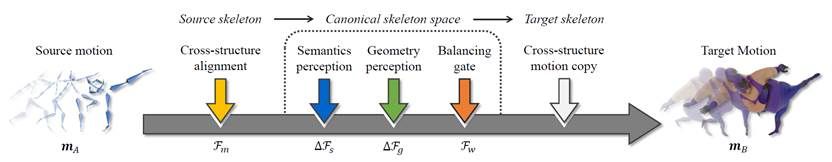

在本工作中,研究团队提出了一种新的残差运动重定向结构(M-R2ET)用于带蒙皮角色的运动重定向。该结构依赖于一个跨结构骨骼对齐模块用于匹配源角色骨骼与目标角色骨骼,以及两个神经网络运动修正(motion modification)模块来调整源运动,使源动作逐步适应目标骨架和形状。

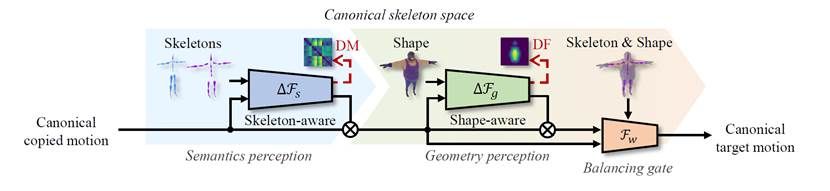

首先,该系统利用跨结构骨骼对齐模块进行运动的初步复制。其次,利用课题组设计骨架语义感知模块(skeleton-aware module)用于保留源运动语义,设计形状感知模块(shape-aware module)用于感知目标角色的几何形状,以减少相互渗透和接触缺失。

随后,利用课题组提出的基于距离损失的驱动,使上述两个模块自主学习实现对源运动的残差运动进行修改,达到在无需后处理的情况下,在单个推理中生成合理的目标运动。为了平衡这两种运动修正,课题组进一步设计了一个平衡门(balancing gate),在两种运动修正之间进行线性插值。在公共数据集Mixamo上的大量实验表明, M-R2ET模型实现了最先进的运动重定向性能,并在保留运动语义以及减少相互渗透、接触缺失之间提供了良好的平衡。

运动修正模块

核心贡献:

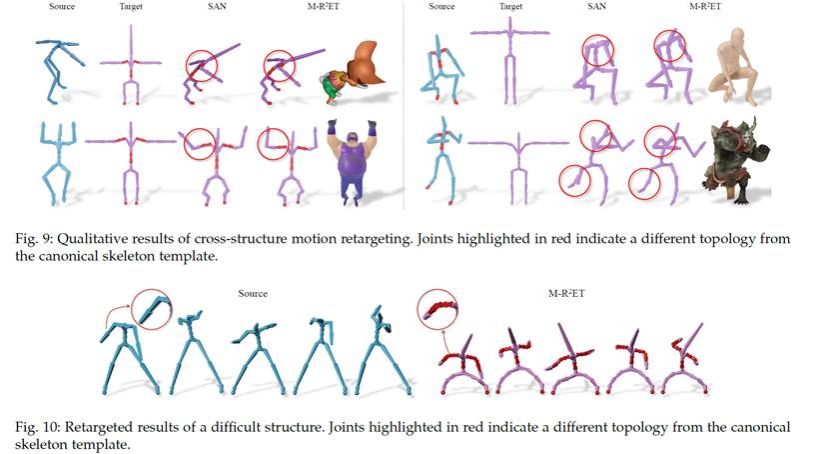

1. 提出了一种新颖的残差网络结构(R2ET)用于神经网络运动重定向,该结构包括骨架感知修改模块、形状感知修改模块和平衡门。在该结构的基础上,拓展到了模块化的运动重定向系统(M-R2ET),实现在统一的标准骨骼结构下解决跨骨骼运动重定向问题。

2. 设计了跨结构骨骼对齐模块用于将同胚的骨骼结构匹配的标准骨骼模板上,实现了跨骨骼运动复制以及骨骼结构的统一化,并有助于动作语义及几何感知。

3. 开发了一个归一化的关节距离矩阵来指导骨骼感知模块训练,用于显式运动语义建模。另外,引入了两个距离场来实现可微分的姿态调整学习,用于感知角色形状。

4. 大量实验表明,M-R2ET在运动重定向的几何及语义精度上均达到了先进的性能。

实验对比

实验结果表明,与现有方法相比,M-R2ET系统迁移的运动更加逼真、连贯,并且能够更好地与源运动匹配。

其次,M-R2ET系统在动作语义相似度、几何质量等方面都取得了显著的改进。与其他模型相比,M-R2ET能够显著减少穿模并维持动作语义。

M-R2ET技术在跨骨骼蒙皮角色运动重定向领域具有明显的优势和潜力,为动画制作提供了新的思路和方法,有望推动动画制作技术的进一步发展和普及。

论文预览版链接:https://ieeexplore.ieee.org/document/10495176

代码连接:https://github.com/Kebii/R2ET

课题组网站:http://tuzhigang.cn/

行为理解与视觉感知课题组(HUVPR-Lab)公众号: